Regular la inteligencia artificial (IA) de manera efectiva es uno de los retos más determinantes de nuestra era. Esto significa aprender de las lecciones y buenas prácticas que están siendo implementadas en normativas alrededor del mundo para asegurarnos de encaminar a estas nuevas herramientas en la dirección correcta.

Cuando hablamos de inteligencia artificial olvidamos que por décadas fue el motor de investigación en áreas STEM —Ciencia, Tecnología, Ingeniería y Matemáticas por sus siglas en inglés— de alto nivel. La realidad es que la mayoría de nosotros nos empezamos a dar cuenta del poder y el potencial de esta tecnología muchísimo tiempo después, probablemente a través de plataformas como Facebook, Google o Amazon y, recientemente, con la llegada de ChatGPT, las computadoras personales con IA y la Meta IA, ya disponible hasta en nuestro WhatsApp. Lo que es una realidad es que la IA se está convirtiendo en algo esencial, no solo para muchas industrias, sino también para nosotros, los “simples mortales”.

Una IA más accesible y útil

La IA empezó a popularizarse entre el público general alrededor de la década de 2010 con el surgimiento de herramientas y aplicaciones como el reconocimiento de voz, la traducción automática, las recomendaciones personalizadas y los asistentes virtuales. Está transformando muchas áreas de nuestras vidas porque, aceptémoslo, hace que nuestras interacciones diarias sean mucho más cómodas y efectivas. “Alexa, ¿cómo va a estar el clima hoy?”. ¡Te amo, tecnología!

Hace unos años me costaba trabajo pensar que la IA llegaría a alcanzar la sofisticación y accesibilidad que hoy tiene. Lo veía como algo muy futurista o más bien limitado a campos como la investigación científica o a las películas del futuro, no como algo integrado en mi vida diaria. Pero, ¡oh, sorpresa!, qué equivocada estaba.

¿Entonces qué nos preocupa?

Existen tres áreas principales de inquietud para la sociedad respecto a la ética en inteligencia artificial:

- La privacidad y vigilancia

- Sesgo y discriminación

- El juicio humano (probablemente la más compleja).

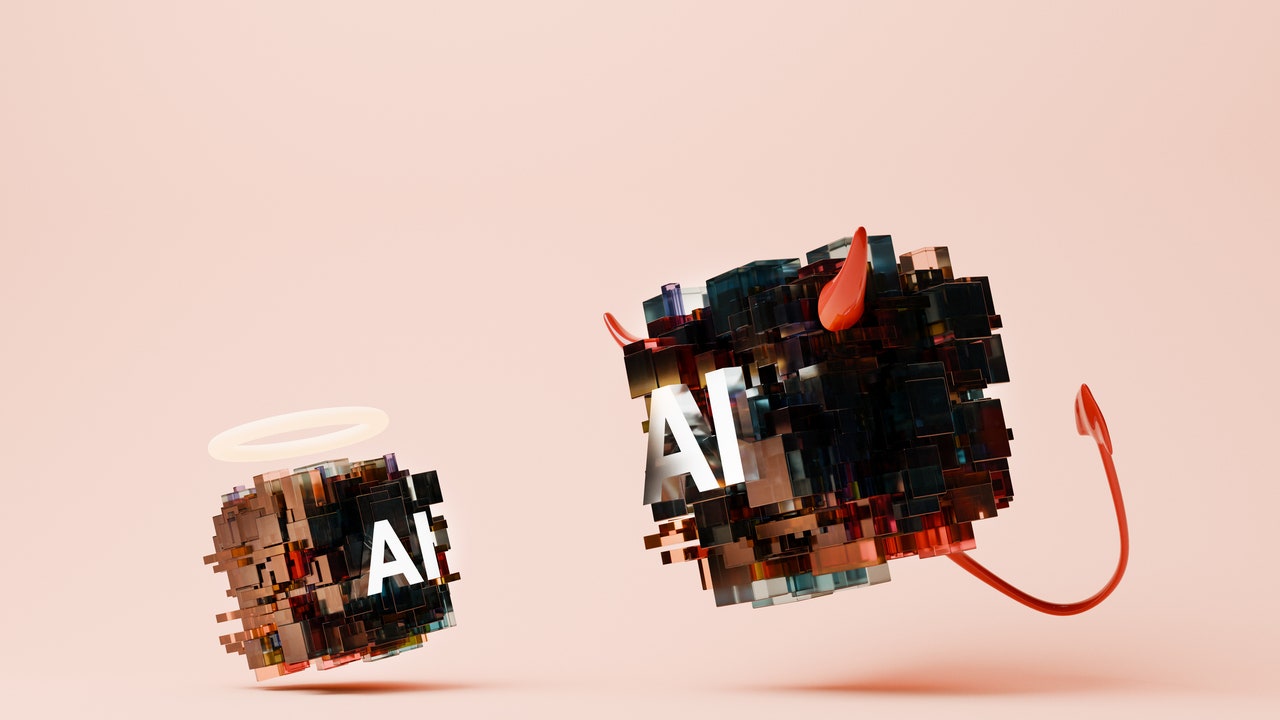

Son estas tres preocupaciones las que más han influido en el pánico —no fundamentado— hacia la IA. Dado su poder, algunos argumentan que el uso de la inteligencia artificial debería estar estrictamente regulado. Sin embargo, hay poco consenso sobre cómo debería hacerse y quién tendría que establecer las reglas. Entonces, ahí llega el desafío.

La necesidad de una IA responsable es una realidad y no debemos dejarla a un lado, especialmente ahora que, aunque la inteligencia artificial ha recorrido un largo camino, aún queda mucho por descubrir a medida que la tecnología evoluciona. Estamos a tiempo de encontrar formas de utilizar estos avances para impulsar cambios positivos y prevenir riesgos.

Cómo dirigir a la IA por un buen camino

Claro que “del dicho al hecho hay mucho trecho” y “del plato a la boca se cae la sopa”. Sin embargo, estoy convencida de que existen algunos puntos en los que, por ahora, nos podemos enfocar para asegurarnos de que la IA siga una trayectoria ética y positiva:

- Los sistemas de IA deben demostrar transparencia y responsabilidad en cuanto a cómo toman decisiones y cómo funcionan sus procesos de razonamiento.

- Las organizaciones y desarrolladores deben asumir su responsabilidad social y estar conscientes de las consecuencias de sus tecnologías, por lo que necesitan concentrarse en el bienestar social y en contribuir positivamente a la sociedad.

- Para evitar sesgos y respetar la privacidad y autonomía de los usuarios, las decisiones tomadas por la IA deben estar alineadas con los principios éticos y valores humanos fundamentales.

- Sí o sí debemos asegurarnos de que los sistemas de IA sean inclusivos y consideren la diversidad de las distintas experiencias humanas para evitar la discriminación.

- En cuanto a seguridad y protección de la privacidad, es esencial que las aplicaciones de IA estén diseñadas con medidas robustas de seguridad cibernética para proteger datos personales que podrían ser utilizados maliciosamente.

- La supervisión. Mantener una vigilancia, revisiones y chequeos constantes para corregir cualquier sesgo, error o comportamiento no deseado. ¡Esto es un aspecto vital en el uso responsable de la IA!

- Estoy convencida de que la colaboración, regulación y el trabajo en equipo entre diferentes sectores —academia, industria, gobierno— son necesarios para establecer estándares y regulaciones claras que guíen el desarrollo ético de la inteligencia artificial.

Usuarios al timón

Podríamos decir que, como usuarios, tenemos la sartén por el mango. Por supuesto que aún existen errores y sesgos por parte de la IA, pero si nosotros somos más críticos —porque estamos bien informados— podemos ayudar a crear una cultura de responsabilidad en el uso de la tecnología. Con nuestra retroalimentación, los desarrolladores pueden detectar y ajustar problemas en las aplicaciones para garantizar que no haya errores ni sesgos. ¡No tengas miedo a señalar algo que te hace ruido!

De la misma manera, familiarizarnos con las políticas y regulaciones relacionadas con la privacidad y el uso de la IA en nuestra región nunca estará de más, así como siempre cuestionar la información proporcionada por sistemas de IA para hacer un double-check antes de tomar decisiones basadas en ella.